Aruba ESP 数据中心连接设计

Aruba Edge Services Platform(ESP)数据中心提供灵活且高度可靠的网络设计,以确保所有授权用户能够有效、可靠地访问应用和数据,同时简化操作并加速服务交付。

Aruba ESP 数据中心是基于以下交换机模型构建的:

- Aruba CX 8xxx 以太网交换机

- Aruba CX 9300 以太网交换机

- 配备Pensando的Aruba CX 10000以太网交换机

- 用于带外(OOB)网络管理的Aruba CX 63xx以太网交换机

目录

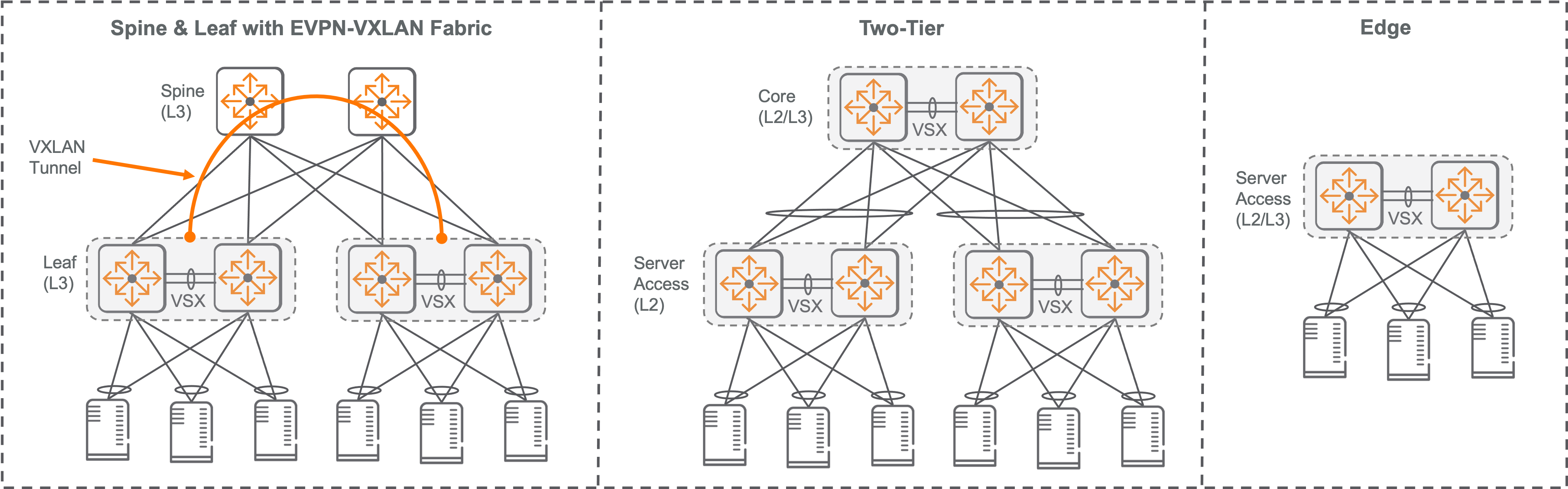

Aruba ESP 数据中心拓扑结构

Aruba ESP数据中心能够在组织内的任何地方处理集中和分散式工作负载。无论是哪种设计,都可以通过主机上行捆绑来提供高吞吐量和弹性,以满足关键任务工作负载的需求。此外,它还支持二层灵活部署,以适应应用需求并实现虚拟主机的移动性。

Aruba CX交换机为数据中心的3层服务提供了强大的平台。主要使用Aruba CX 8xxx、CX 9300和CX 10000系列以太网交换机来实现Aruba ESP数据中心设计,这些交换机在专为承载数据中心流量而设计的容错平台上,能提供低延迟和高带宽,且只有1U的外形尺寸。

Spine-Leaf 与 VXLAN Fabric 概述

现代且灵活的数据中心设计基于Spine-Leaf路由架构,采用EVPN-VXLAN叠加技术。这种设计对企业有很大好处,特别是对那些本地工作负载持续增长以及工作负载分布在多个数据中心的企业。

Spine-Leaf的底层设计通过在Leaf交换机与Spine交换机之间建立冗余的三层链接,确保了系统的高可靠性和水平扩展能力。这种基于Clos拓扑的设计提供等价多路径(ECMP)路由功能,实现流量负载均衡,并且支持快速故障转移,以应对链路或交换机出现故障的情况。此外,完全网状架构可以根据需求简单地添加一个新的Spine交换机来增加容量。

EVPN-VXLAN 叠加技术使得 VXLAN 隧道可以在整个数据中心实现全面的二层邻接。这样,客户既能满足传统服务需求,又能通过在叠加层连接物理上分散的二层段来更新他们的网络。即使是地理位置遥远的数据中心也可以逻辑地扩展其二层和3层段。

EVPN-VXLAN 支持在数据中心内对资源组进行分段,以满足多租户和各种角色(如生产、开发、租户及需严格遵守法规的主机)的分离需求。

两层(Two-Tier)概述

企业如果在单一位置有大量本地工作负载,可以从两层数据中心设计中获益。这种方法利用标准协议(如链路聚合控制协议LACP、生成树协议STP和开放最短路径优先OSPF)来保证足够的容量和可靠性。主机通过虚拟交换扩展VSX和多机箱链接聚合组MC-LAG双连接到两个架顶ToR交换机。每个ToR交换机都通过二层VSX/MC-LAG链接双连接到数据中心核心。在核心与服务器接入层之间广泛使用支持二层VLAN,并且主要采用基于LACP的MC-LAG以防止环路形成。数据中心核心为主机提供三层服务并向外部网络进行路由。

两层数据中心的物理结构为未来向EVPN-VXLAN Spine-Leaf数据中心迁移提供了一条途径。

边缘数据中心概述

对于已经将大部分工作负载迁移到云端,不再需要大型本地数据中心的企业,他们可以利用现有的园区网络配线柜或小型服务器房间来处理小规模的本地工作负载。

同一款AOS-CX交换机既可以为用户和物联网(IoT)设备提供有线连接,也可用于服务器接入。

边缘数据中心能够提供高带宽和低延迟接入计算及存储资源,以满足可能无法适应云部署的分布式工作负载需求。

一般设计考虑因素

带外管理

Aruba ESP数据中心的设计通过专用管理LAN连接交换机和主机的远程管理端口。通常,每个机柜都会配置一个独立的管理交换机进行离线操作。这种专用管理交换机保证了与数据中心基础设施的稳定连接,实现自动化、编排和管理,并且在调整数据中心数据平面配置时不会有断开管理访问的风险。

架顶设计

将交换机部署在机柜顶部可以缩短主机与交换机之间的电缆长度。这是一种更模块化的解决方案,其中从主机到交换机的布线都被包含在封闭的机柜内,只有交换机上行链路需要穿出封闭装置。此方法能有效降低向数据中心增加新设备时带来的复杂性。

在Aruba ESP数据中心,每个服务器柜都由一对备份交换机提供服务。这样,双宿主主机可以通过MC-LAG捆绑包与两个物理交换机连接,以实现故障容错和增加处理能力。Aruba CX交换机采用了两种策略来支持MC-LAG:VSX交换机配对和虚拟交换框架(VSF)的堆叠方式。

VSX实现了一种高可用性的分布式和冗余架构,能在升级过程中保持稳定运行。它将两个交换机的控制平面虚拟化,在二层网络上作为单一设备运行,而在三层网络上则作为独立设备运行。从数据链路角度看,每个设备都会执行独立的转发查找以确定如何处理流量。某些转发数据库,如MAC和ARP表格,则通过专用的交换机间链接(ISL)在两台设备之间进行同步,这是由VSX控制平面完成的。同时,每台交换机都会独立建立自己的三层转发数据库。

在部署一对VSX模式的交换机时,至少需要两个端口作为ISL的LAG成员来支持控制平面功能,并在两台交换机之间充当数据链路。ISL端口的速度应与上行链路端口的速度保持一致。

VSX需要在成员间进行保活(keepalive)操作以便检测”脑裂”状况,这种情况通常会在ISL的通信中断时出现。最佳做法是在专用管理网络上使用OOBM端口来配置保活功能。另外,也可以通过环回IP地址或专用的低速物理端口来处理保活流量。为了增加系统弹性,我们支持通过冗余路由路径进行基于环回的通信。

VSF将两至十个CX 6300交换机整合为一个采用环形拓扑的高可靠性堆叠系统。Aruba ESP数据中心利用VSF堆叠技术,连接1 Gbps接入主机的机柜与上游Leaf交换机。每个VSF堆叠都以统一的二层和3层控制平面运行。在这个系统中,有一个交换机成员作为Conductor角色运行,负责管理所有其他堆叠交换机成员。第二个成员则作为Standby角色运行。 Conductor和Standby交换机会同步状态和配置信息,因此当出现故障时,它可以顶替 Conductor 角色进行工作。通过每个堆叠成员的OOBM端口连接到公共管理网络来监控“脑裂”情况。

选择一个顶架交换机,它支持每个端口的1、10和25 Gbps接入连接速度,以确保最常见的连接速度和向后兼容性。通过升级收发器、DAC或AOC,可以简单地增加这些连接速度。

Aruba CX 9300-32D交换机为高吞吐计算机柜提供100和200 Gbps的主机连通性以及400 Gbps的上行链路。通过使用分支光缆和AOC,可以将四个基于QSFP56的100 Gbps主机网卡、两个基于QSFP56的200 Gbps主机网卡或两个基于QSFP28的100 Gbps主机网卡连接到一个CX 9300-32D交换机物理端口。

在选择架顶交换机时,请记住以下几点:

- 服务器连接数量和种类:虽然标准的顶架交换机配置可以支持48个主机端口,但Aruba CX 8360系列也提供了低密度的顶架选项。您可以使用Aruba CX 6300系列将一组1 Gbps的主机进行连接。

- 主机连接速度:为了便于管理,我们将相同连接速度的主机集中放置在同一机柜和交换机上。请注意,调整特定接口的端口速度可能会影响到其周围的接口。因此,在规划需要多种连接速度的机柜时,请考虑到接口组的大小。对于需要以100 Gbps或200 Gbps进行连接的高速存储和计算主机,我们推荐使用CX 9300-32D交换机。

- 顶架到Spine/核心的连接性: 顶架交换机型号支持多种上行端口密度。上行链路的数量和端口速度决定了从主机到数据中心fabric或数据中心核心的收敛比。例如,如果在100 Gbps下部署四个Spine fabric,那么可以为40台以10 Gb连接服务器提供非超额收敛比的fabric。

- VSX上行链路的消耗: 在使用VSX实现冗余时,两个上行端口被用作提供数据路径冗余的ISL,因此无法用于Spine或数据中心核心的连接。

- DSS需求特性:在执行使用AMD Pensando可编程DPU的内联状态防火墙检查的数据中心设计时,需要Aruba CX 10000。

- 冷却设计:我们提供多种交换机型号,以满足从端口到电源和从电源到端口的冷却需求。在后者配置中,可选风道套件能隔离服务器内部热气。布线可能会吸收热量并阻碍空气流动。因此,简洁的线路路径和良好的线缆管理对提高空气流通效率至关重要。

主机连接性

确定计算主机所需的连接类型是设计数据中心的关键步骤之一。通常,服务器硬件有一个以太网RJ45端口,用于连接像HPE iLO这样的无人值守管理设备。这些无人值守端口通常使用Cat5e或Cat6铜线缆与管理局域网上的交换机相连。

通常,我们使用SFP+/SFP28光纤模块、铜直连电缆(DAC)或有源光缆(AOC)来实现10Gb或25Gb的主机连接。DAC对距离的支持有限,并且由于其线规较粗,管理起来比光缆更困难。相比之下,AOC可以支持更长的距离,并且因为它更细,所以管理起来也更方便。尽管如此,DAC和AOC的成本都低于单独购买的光收发器和光纤线缆。

CX 9300交换机支持使用QSFP-DD收发器和AOC实现高速主机连接。这些光学元件和AOC能将单一的400Gbps交换机端口分解为多个200Gbps或100Gbps的低速连接。此外,该交换机还可支持基于QSFP56和QSFP28的主机网卡。关于如何使用分支光缆和AOC,您可以参考AOS-S 和 AOS-CX 收发器指南获取详细信息。

确认主机的网络接口卡(NIC)和顶架交换机是否与同一DAC或AOC兼容是非常重要的。当使用独立的收发器和光缆时,需要检查收发器是否与主机NIC、顶架交换机以及光缆类型匹配。通常情况下,主机支持的收发器类型可能会与交换机支持的不同。因此,在规划新建或升级数据中心时,应始终寻求结构化布线专业人员的咨询意见。

在部署用于IP存储流量的混合网络时,寻找能够支持存储协议卸载的网卡。这样可以通过减轻主机CPU负担来降低存储流量延迟。

应用可以直接部署在只运行一个操作系统的服务器上,这种服务器通常被称为”裸金属”服务器。通过使用虚拟化软件(如VMware ESXi或Microsoft Hyper-V),我们能够在一台物理服务器上模拟出多个主机环境。

Hypervisors包含一个虚拟交换机,它通过二层VLAN为每个虚拟机(VM)提供连接。优秀的数据中心设计应能支持使用无标签和带有VLAN标签的二层和三层连接,以满足到服务器及其内部虚拟交换机所需的连接。Aruba Fabric Composer (AFC) 提供了对服务器与Aruba ToR 交换机之间配置的可视化和编排功能,确保正确建立这些连接。

主机移动性是指在不更改主机网络设置的前提下,能够在数据中心网络内部移动物理或虚拟主机的功能。这对于虚拟化的主机来说非常有用,因为它可以确保计算资源得到优化,应用程序具有高度可用性,并且分布式工作负载连接有效。EVPN-VXLAN fabric和两层数据中心支持灵活的主机移动性,允许所有数据中心VLAN存在于所有ToR交换机上。EVPN-VXLAN设计还提供了通过路由底层进行二层邻接隧道,并且可以在不同数据中心位置之间逻辑扩展二层邻接。

Spine-Leaf配合EVPN-VXLAN Fabric

EVPN-VXLAN fabric提供了一个虚拟的二层网络叠加,这是从支持其的物理网络底层抽象出来的。它允许主机在同一VLAN网络段内运行,即使被三层边界隔开,也可以通过封装流量到隧道中实现通信。此外,EVPN-VXLAN中的对称集成路由和桥接(IRB)功能可实现叠加网络段之间的三层路由。

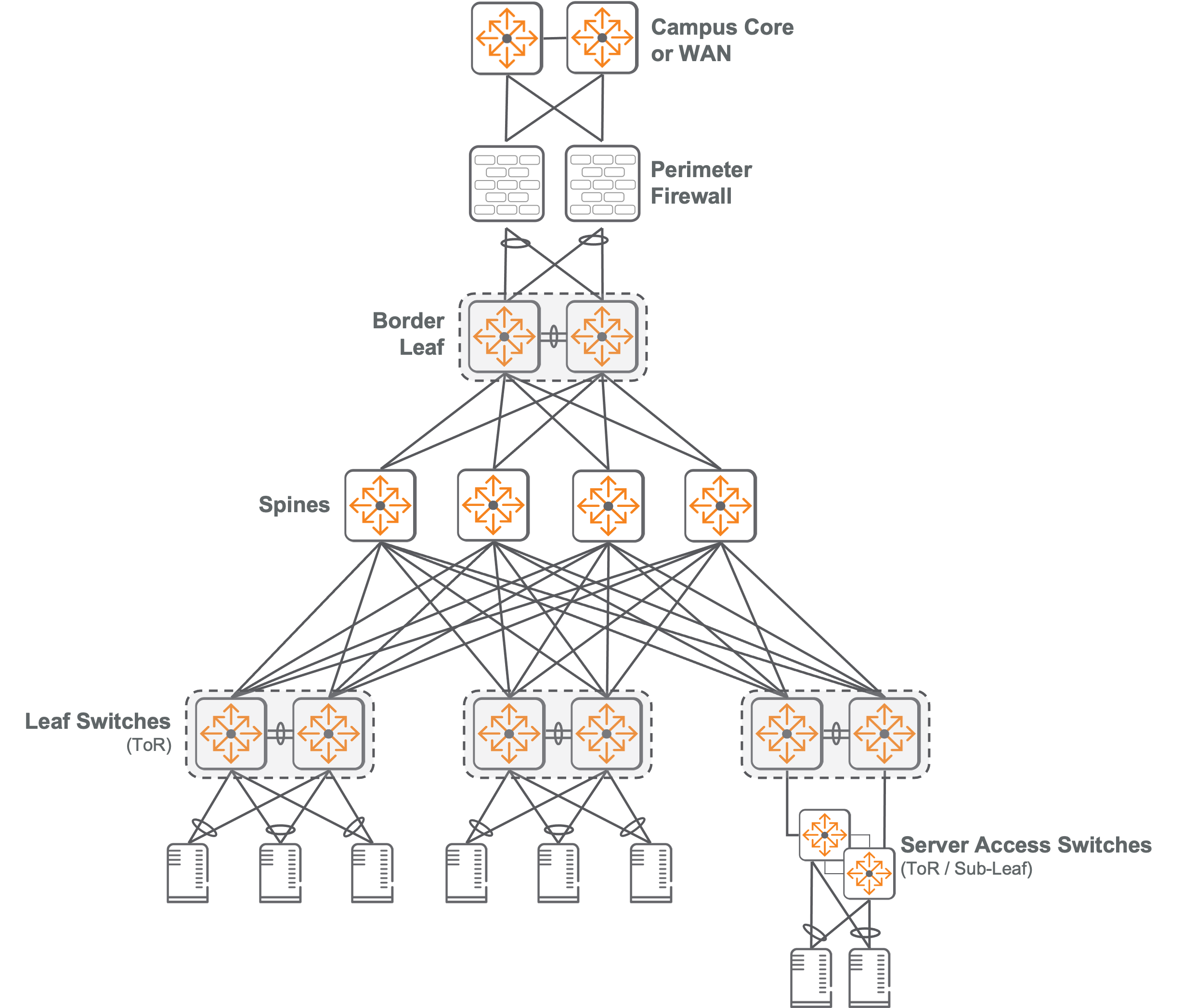

物理拓扑

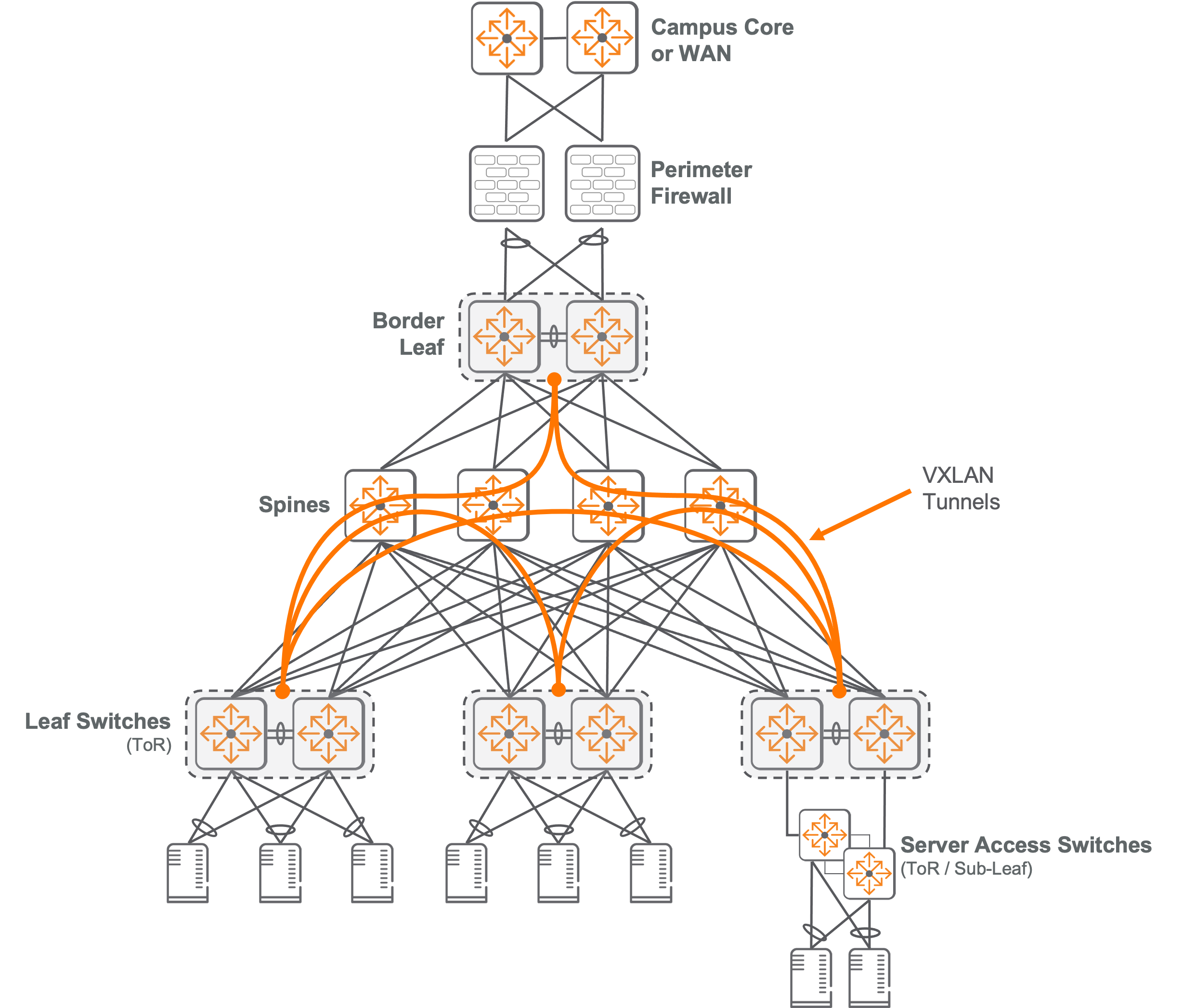

下图展示了EVPN-VXLAN解决方案中所有角色的物理连接方式。

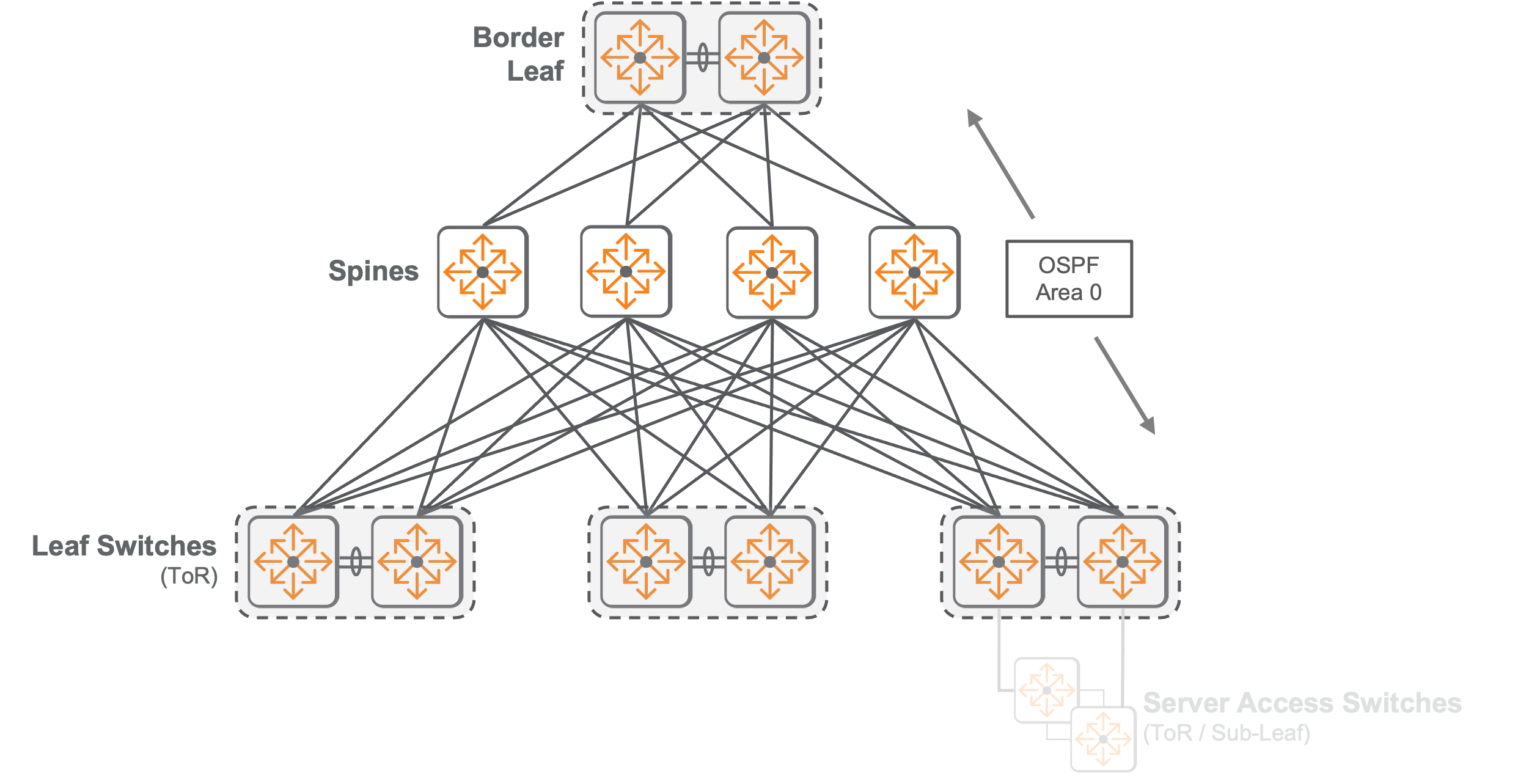

底层(underlay)网络设计

EVPN-VXLAN数据中心网络的底层确保了交换机间的IP连接,使得VXLAN隧道流量(叠加网络)能在Leaf交换机上的隧道端点之间转发。

我们采用了基于3阶Clos的Spine-Leaf fabric拓扑结构来实现底层网络。这个网络被设计为三层路由模式,每个Leaf通过专门的路由端口与每一个Spine相连。这种Spine-Leaf拓扑结构优化了性能,提高了可用性,并降低了延迟。因为从任何一个Leaf到所有其他Leaf交换机的路径都不会超过一跳,并且还可以通过多条负载均衡路径进行传输。

Spine-Leaf拓扑提供了一种灵活且可扩展的网络设计方案,能够在不影响现有网络的前提下适应增长。这种设计可以从一个小型的单层或两层fabric开始,通过增加容量而无需更换已有硬件。添加Leaf交换机可以为新机柜增加计算和网络附加存储(NAS)能力;而添加Spine交换机则可以提升Leaf交换机之间的东西向fabric能力。

这种拓扑结构大致类似于机箱式交换机的架构,其中Leaf交换机相当于接口线卡,Spine相当于提供线卡之间数据能力的机箱fabric。

Aruba ESP数据中心采用OSPF作为其基础路由协议,以在所有fabric交换机间传递基础IP可达性信息。OSPF是一种被广泛使用且易于理解的内部网关协议(IGP),它提供了直接配置和快速收敛的功能。当加入EVPN-VXLAN叠加时,基础路由表会变得较小,主要包括环回IP地址来建立叠加路由协议邻居关系和VXLAN隧道端点的可达性。通过在底层实施OSPF路由,可以选择支持多个fabric环境的叠加路由协议。为了降低复杂度,推荐使用单一OSPF区域和点对点接口。

在Spine交换机和Leaf交换机的连接接口上,将二层和IP最大传输单元(MTU)设置为9198字节,以防止在添加VXLAN封装时产生过大的分片。

服务器不参与交换机的底层路由,它们只通过二层链接连接到上游的Leaf交换机。

Spine 设计

Spine层为Leaf交换机提供了高速的路由连接。在Spine-Leaf架构中,每个Leaf交换机都与每个Spine交换机相连。从Leaf到Spine的所有连接应使用同样的链接速度,以确保网络内部存在多条等价路由。这不仅可以实现基于ECMP的负载均衡,还能在链路故障时保证连通性。

所有Spine交换机必须型号相同。Spine交换机的端口容量决定了单个Spine-Leaf实例中能连接的最大Leaf交换机数量。若采用冗余ToR设计,那么可连接的最大Leaf数量则为Spine端口数的一半。

通常,我们会使用两个spine交换机来构建高可用性网络。为了提升fabric的容量和错误冗余度,我们可以添加更多的spine交换机。在底层,增加额外的spine可以降低故障时产生的影响力。如果单独失去一个spine,整体fabric容量将按以下方式减少:

- 2个Spine:容量减少50%

- 3个Spine:容量减少33%

- 4个Spine:容量减少25%

Spine的最大数量取决于具有最少上行链路数的Leaf交换机模型。在冗余架顶设计中,Spine的最大数量等于具有最少上行链路数的Leaf交换机的上行端口总数减去两个,这是因为两个上行链路被用作ToRs之间的VSX互连交换机链接(ISL)。而在单一架顶设计中,Spine的最大数量则直接等同于具有最少上行链路数的Leaf交换机的上行端口总数。为了使ECMP能够有效运作,每个架顶交换机都必须连接到每一个Spine。

基于CX 9300的Spine在使用分线电缆时,能够提供高密度机柜支持。CX 9300有能力将单个400Gbps的Spine端口拆分为四个通过单模光纤连接的100Gbps Leaf交换机端口。此外,它还可以通过多模光纤和AOC来实现每个Spine端口上两个100Gbps连接的Leaf交换机。这使得CX 9300可以将其物理端口数量所支持的机柜数量增加一倍或者四倍。

在Leaf节点中,使用CX 9300可以扩展到极限水平的CX 9300 Spine。当一半可用端口被用于主机连接时,我们可以构建一个由14个Spines组成、总带宽为5.6Tbps的fabric来支持冗余ToR设计。如果是单一ToR设计,则可以实现一个由16个spines组成、总带宽为6.4Tbps的fabric。只要机柜数量允许,CX 9300 的Spine和Leaf组合就能够支持每个Spine连接多条链路。这种部署模型能够支持非常高的吞吐量,并包含100Gbps连接存储和计算主机的机柜。

在选择交换机时,请考虑以下因素:

- 确定机柜的媒体需求和带宽需求。

- 确定是否安装单个或冗余的架顶交换机。

- 根据当前的计算和存储需求,确定需要多少个机柜。

- 确定支持计划中的机柜所需的Spine交换机。

- 设计数据中心网络时,确保其容量不超过50%,以便为未来的增长留出空间。

在确定Spine交换机的物理位置时,我们需要考虑其与Leaf交换机的距离和连接它们所使用的媒体类型。一般来说,Spine到Leaf的连接是40 Gb或100 Gb光纤,采用四路SFP(QSFP)收发器或AOC。在这种情况下,电缆和收发器是集成在一起的,类似于DAC。Aruba 9300-32D能够支持高达400 Gbps的Spine到Leaf连接,适合需求更高速度数据中心应用。

叠加(overlay)数据层网络

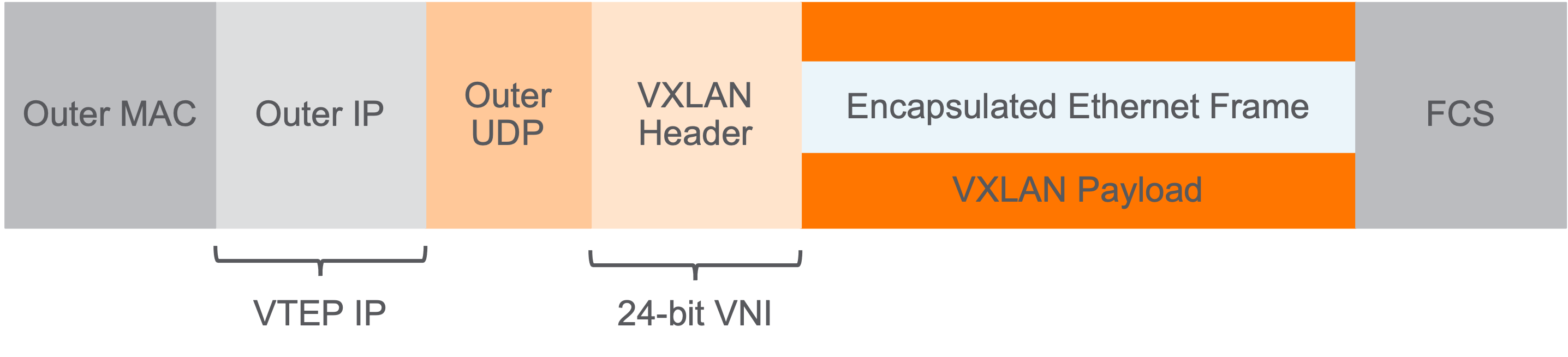

叠加网络通过VXLAN隧道实现,为直接连接到Leaf交换机的工作负载提供二层和三层虚拟化网络服务。在VXLAN叠加拓扑中,分布式二层和三层段由VXLAN网络标识符(VNIs)标记。对称IRB使得所有Leaf节点间可以连续进行二层转发和三层路由,从而支持叠加网络。。

VXLAN隧道端点(VTEP)是Leaf交换机中负责处理建立和结束点对点叠加网络隧道的功能。它在UDP数据报中将二层以太网帧封装和解封到一个VXLAN头部。源VTEP会分配一个虚拟网络标识符(VNI),用于通知目标VTEP关联的封装帧的VLAN或路由表信息。当VSX冗余Leaf交换机在机柜中部署时,就形成了逻辑上的单一VTEP。通过使用OSPF协议,可以在底层网络中分发VTEP IP地址。Spine交换机提供IP传输服务来支持叠加隧道,但不参与VXLAN流量的封装/解封操作。

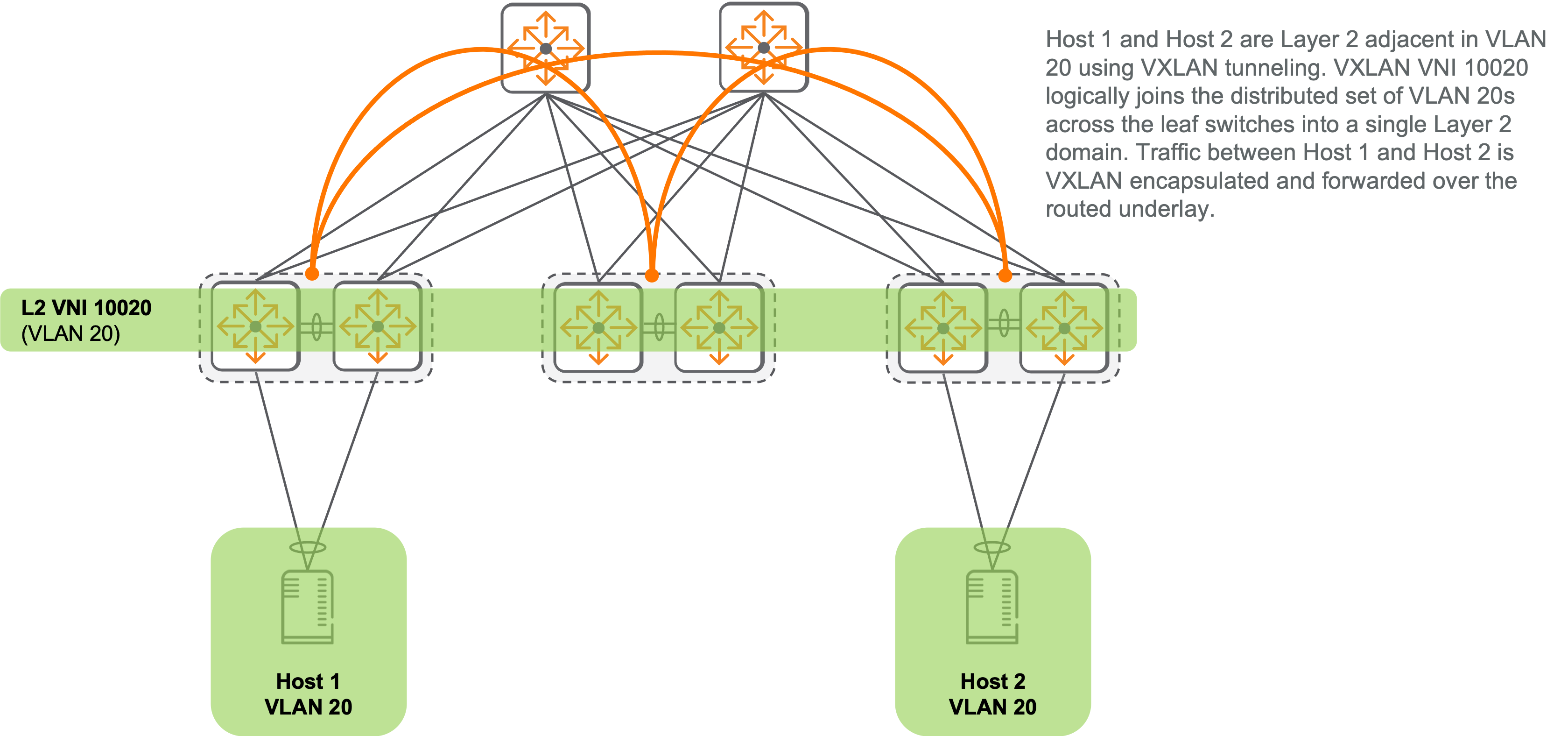

以下图解展示了VXLAN数据平面网络,它是由Leaf交换机VTEP间的全网状VXLAN隧道构成。

服务器不包含VTEP,也不参与VXLAN转发。它们通过扩展来自fabric leaf交换机的VLAN,以支持数据中心主机连接到叠加层。

二层VNI代表一个独立的广播域,这与传统的VLAN ID相似。它在fabric中与各交换机上的VLAN关联,并将分散的VLAN集合整合为一个统一的二层广播域。当一个封装了VXLAN协议的数据帧到达拥有二层VNI功能的VTEP终端时,交换机会解开该数据帧,并根据与此VNI相关联的VLAN的MAC地址表进行原始转发。

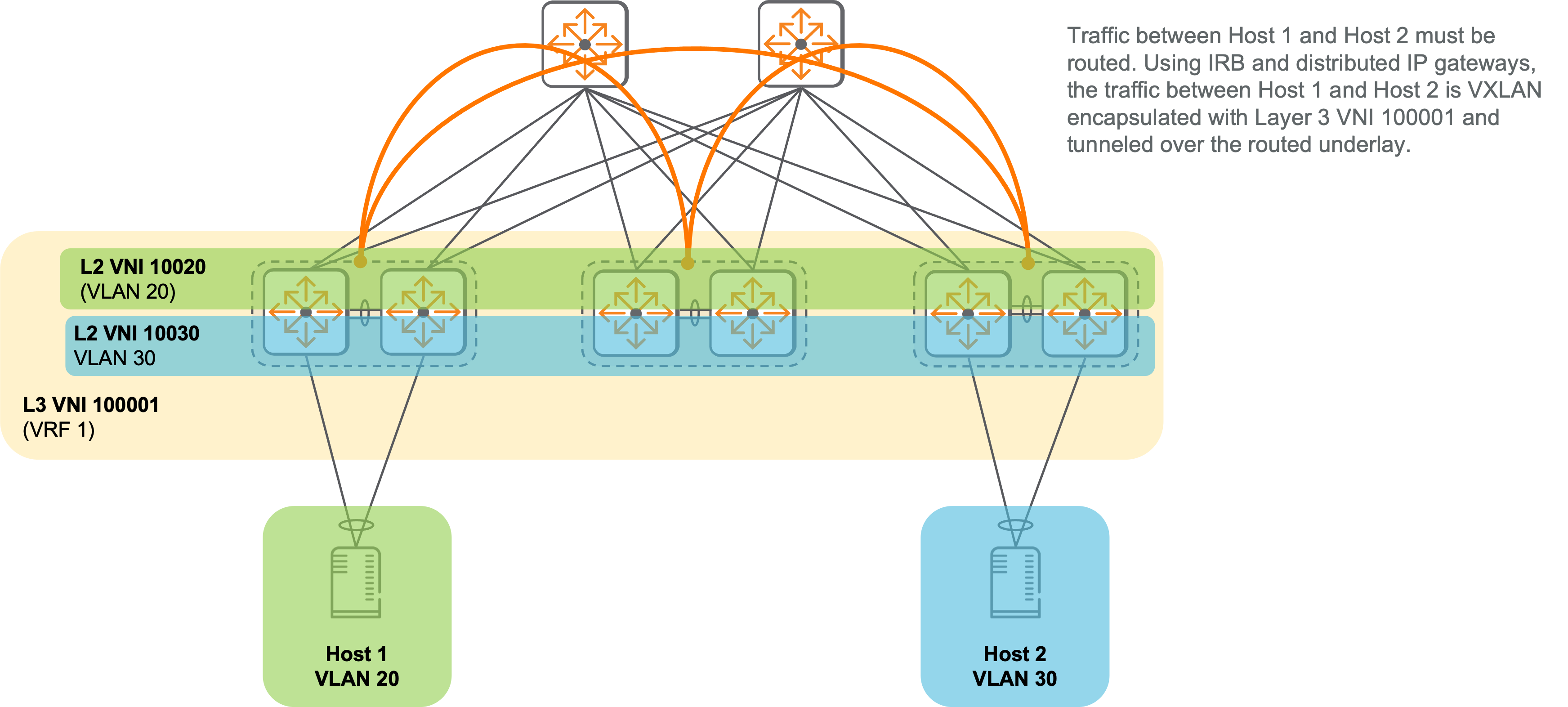

交换机通过实施虚拟路由和转发(VRFs)来支持多个路由领域。每个VRF都有一个独立的路由表,用于基于该表进行流量转发的接口,以及构建该表的路由协议。不同的VRF可能会包含重叠的IP地址范围,因为各自的路由表是分离的。EVPN-VXLAN覆盖网络至少需要一个非默认VRF作为覆盖VLAN SVIs和已经配置过路由接口的容器。可以使用多个VRF来提供用于多租户环境和策略执行所需的分段功能。

三层VNI将VXLAN封装的流量与VRF进行关联。当一个带有三层VNI的VTEP接收到VXLAN封装的数据包时,该数据包会被解封装,并根据相关联的VRF路由表进行转发。

对称IRB(Symmetric IRB)采用的是分布式IP网关模型,其中fabric主机VLAN的网关为任播IP地址。在Aruba的Active Gateway特性下,每个交换机上相同VLAN都被赋予了相同的虚拟IP地址。同时,一个分布式虚拟MAC地址也与这个虚拟IP绑定。此策略支持活动VM客户端在连接到位于不同机柜中的交换机hypervisors之间进行移动。

主机必须路由的流量会接触到分配给其直连Leaf交换机的虚拟网关IP地址。源VTEP和目标VTEP都执行路由功能,其中源VTEP指定一个L3 VNI来通知目标VTEP应用于转发的适当VRF。

边界Leaf交换机在EVPN fabric主机与外部网络(例如园区、WAN或DMZ)之间建立连接。通常,我们会在边界Leaf和外部网络间设置防火墙,以实施南北安全策略。

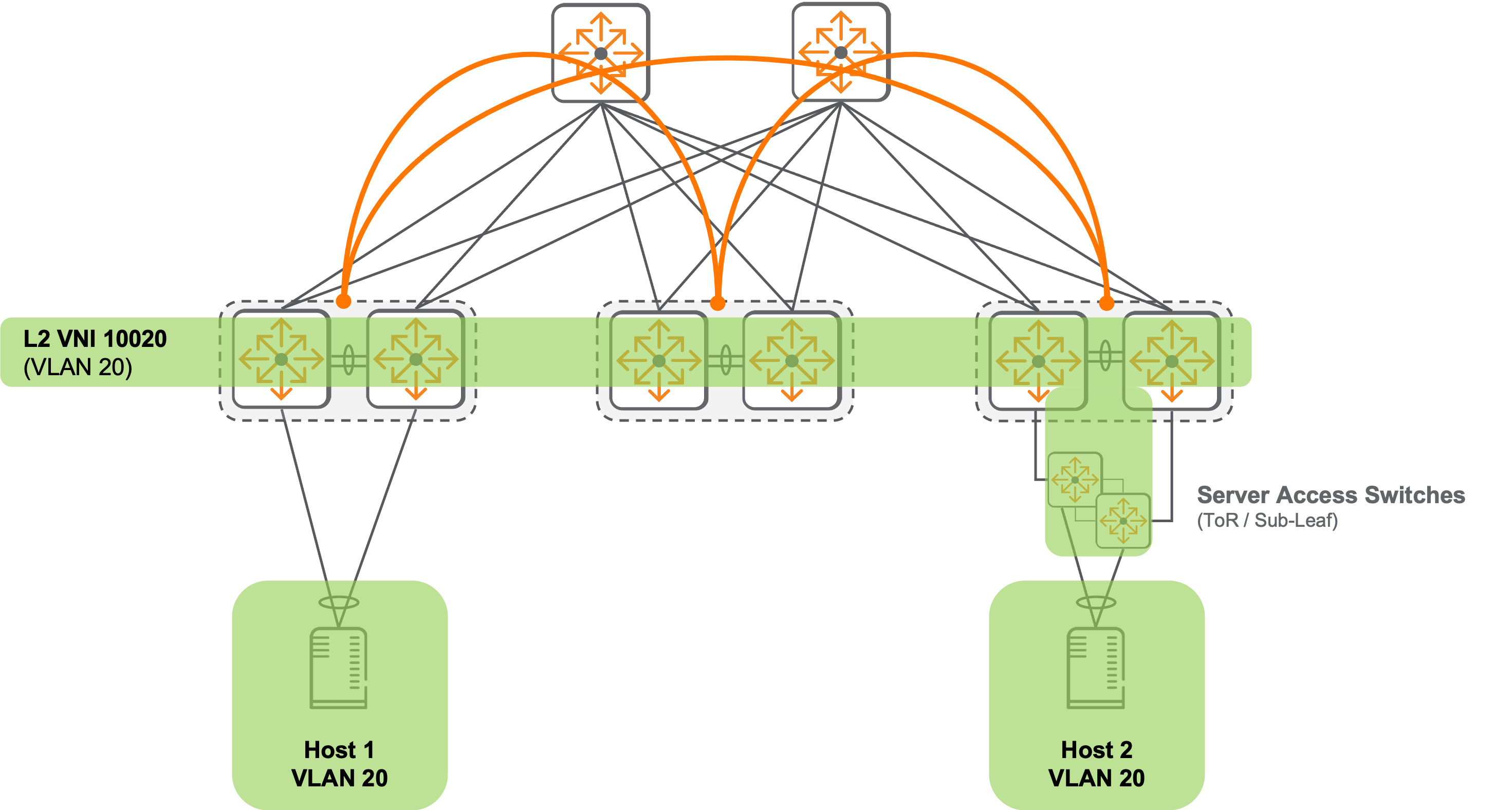

服务器接入层

将服务器接入交换机采用经济高效的二层交换模型,使EVPN-VXLAN Leaf的VLAN叠加能扩展到一组高密度且低速连接的主机。这些主机并不直接参与底层路由或虚拟化叠加。

服务器通过VSX或Virtual Switching Framework (VSF)连接交换机,为附加主机提供二层冗余。启用VSF的交换机在一个或多个与其上行Leaf相邻的机柜中作为单一逻辑堆叠运行。VSF支持对下游主机进行冗余MC-LAGs,并通过带外管理端口监控堆叠成员状态以防止”脑裂”情况发生。

在将已建立的数据中心过渡到EVPN-VXLAN叠加网络时,可以将现有的顶架交换机作为服务器访问开关,通过二层连接至EVPN-VXLAN Leaf,这是过渡策略的一部分。这样做允许我们按照灵活的时间表将现有设施迁移到新的EVPN-VXLAN叠加网络,而无需替换当前使用的顶架交换机。

叠加控制层

VXLAN 控制平面负责分发信息,以共享主机的可达性并动态构建VXLAN隧道。在VXLAN网络中,需要将fabric连接的端点与其对应的VTEP和VNI关联起来,实现端点间的可达性,并跨越所有fabric交换机成员。源VTEP利用这些可达性信息,在VXLAN头部分配一个VXLAN VNI,并在IP头部为目标VTEP分配IP地址。

通过使用以太网链路层协议,我们在上行Leaf交换机处学习了额外的主机。我们采用多协议边界网关协议(MP-BGP)作为控制平面协议,并通过EVPN地址族来分发VXLAN fabric上的叠加可达性信息。BGP负责广播主机IP和MAC前缀。这种方法既最小化了洪泛,又能有效且动态地发现fabric内所有主机。

使用动态填充端点信息的分布式控制层可以带来以下优势:

- 它避免了在大型Spine-Leaf环境中,洪泛学习技术因流量复制而消耗大量带宽的问题。

- 网络配置变得更简单,因为fabric leaf VTEP交换机能自动发现fabric内的对等VTEP交换机,并建立动态VXLAN隧道。

- 分布式控制层提供了冗余性,并在数据中心的fabric交换机之间维持一致的拓扑状态。

- 通过在ToR交换机上使用分布式网关,分布式控制层实现了最优转发。这样,整个fabric中的默认网关地址可以保持不变。

使用EVPN地址族的MP-BGP提供了一种基于标准且高度可扩展的控制平面,能共享端点可达性信息并原生支持多租户。服务提供商已经利用MP-BGP在大规模上实现安全的二层和3层VPN服务。通过采用带有路由反射器的iBGP设计,网络操作得以简化,只需在叶交换机与两个Spine之间建立对等连接。在构建多fabric环境时,需要为每个fabric控制平面设置iBGP。此外还有一些重要的BGP控制平面术语需要注意:

- 地址族 (AF): MP-BGP能够通过将各种地址类型(如IPv4,IPv6,L3VPN等)归类为不同的地址族来交换网络层可达性信息(NLRI)。二层VPN和EVPN后续地址族分别用于在MP-BGP参与者之间广播IP和MAC地址信息。此外,EVPN地址族还包含了建立VTEPs之间VXLAN隧道所需的可达性信息。

- 路由区分符 (RD): 路由区分符让MP-BGP能在同一地址族中处理重复的三层和二层地址,其方式是在原始地址前添加一个独特值。RD仅是一个无固定含义的数字,并不会将地址与路由或桥接表关联。通过确保两个不同VRF中相同地址范围的路由可以在同一MP-BGP地址族中广播,RD支持多租户功能。

- 路由目标 (RT): 路由目标是MP-BGP扩展社区的一部分,用于将地址与路由或桥表关联。在EVPN-VXLAN网络中,通过向MP-BGP EVPN 地址族导入和导出公共VRF路由目标,实现了跨多个VTEP定义的VRF集合的三层可达性。同样地,通过导入和导出L2 VNI定义中的公共路由目标,可以在分布式L2 VNI集合之间分享二层可达性。此外,在不同VRF之间泄漏三层路径也可以通过使用IPv4地址族,并从一个VRF导出后被其他VRF导入的路由目标来实现。

- 路由反射器 (RR): 为了优化 VTEP之间的可达信息分享,我们在Spine上使用路由反射器来简化iBGP的对等连接。这种设计使得所有的VTEP都有统一的iBGP对等配置,从而避免了需要完全网状的iBGP邻居。

MP-BGP EVPN地址族包含了多种路由类型。

- Type 2路由 共享MAC地址和主机IP的可达信息。

- Type 5路由 共享部分fabric交换机可访问的IP前缀,通常用于从边界Leaf向其他Leaf交换机分享默认路由和外部前缀。

- Type 3路由 通过共享VTEP IP和VNI值,可以在fabric内部动态地建立VXLAN隧道。

Type 2路由MAC通告将路由目标值与VLAN关联起来。在fabric中的所有交换机上,对于相同的VLAN ID,应该导入和导出一致的路由目标值。这样可以确保整个fabric的二层连通性得到完全传播。当使用iBGP控制平面时,系统能自动推断出VLAN路由目标,从而简化配置并保证整个fabric的一致性。

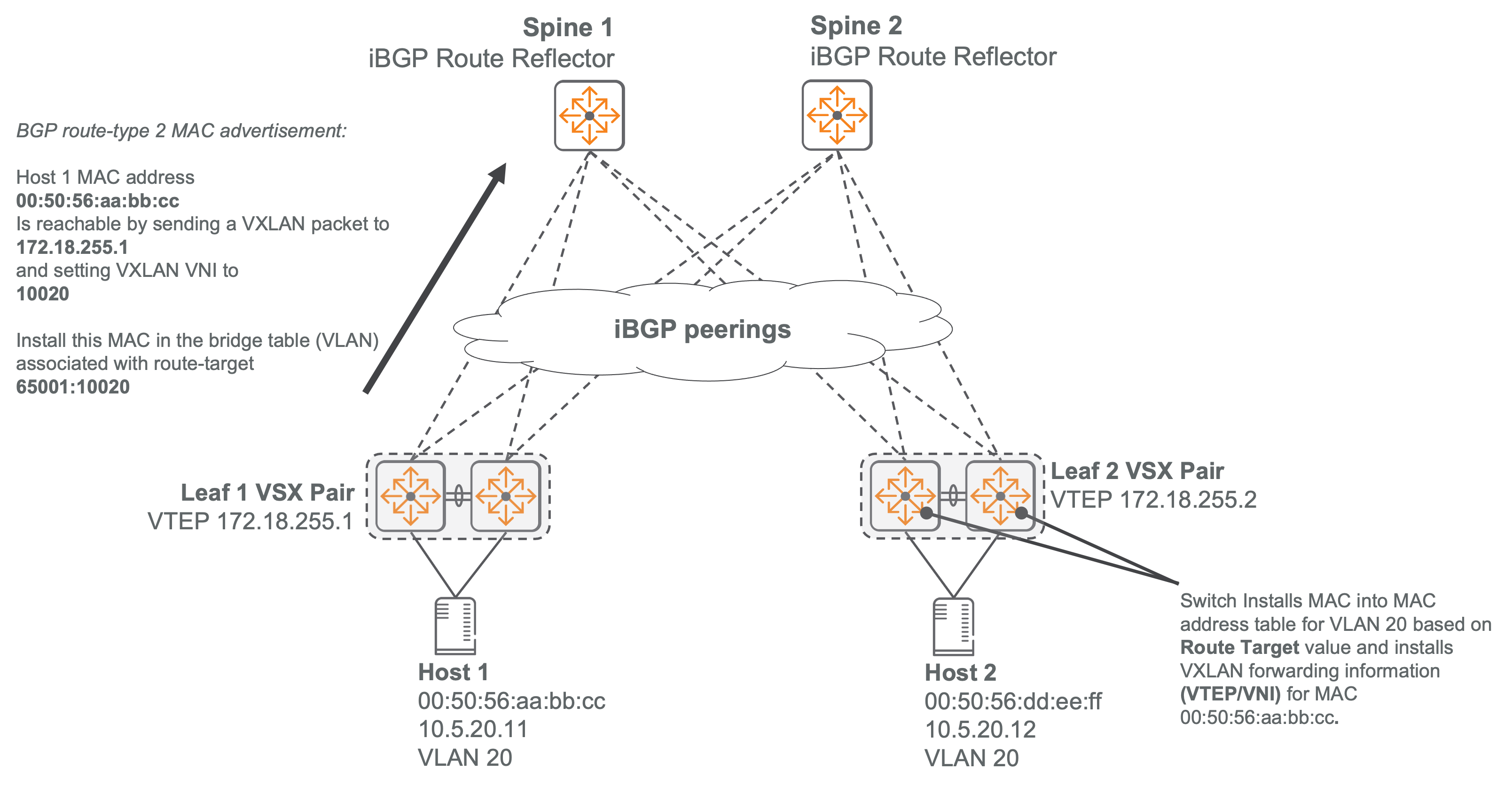

以下图示展示了如何通过使用iBGP控制层来共享EVPN Type 2路由的MAC地址可达性。

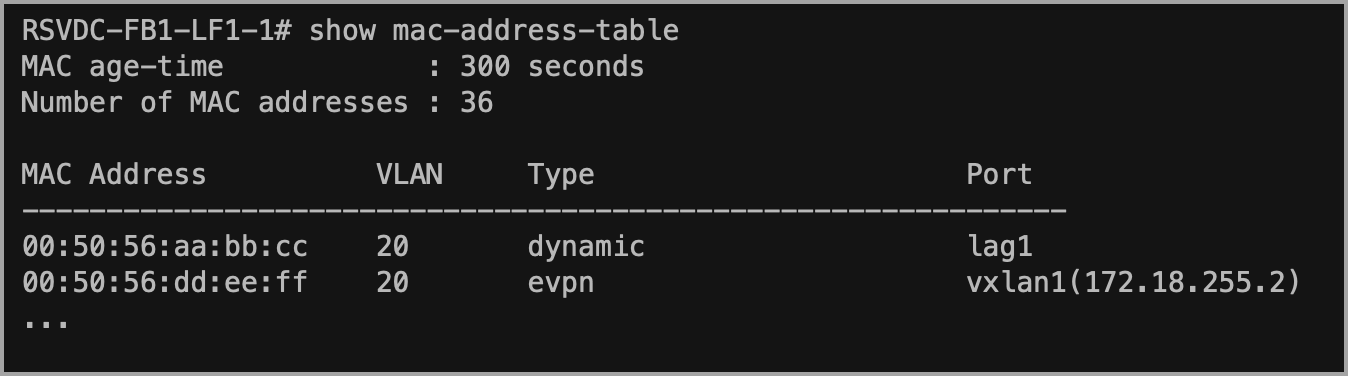

以下截图展示了一个已经被学习并存入MAC地址表的EVPN MAC地址样例,该地址与其VTEP有关联。

Type 5路由的IP前缀是根据路由目标值和VRF的关联来确定的。在fabric中,所有交换机对同一VRF应保持一致的导入和导出路由目标值,以确保3层可达性能在整个fabric中完全传播。

多fabric底层(Multifabric Underlay)

在多fabric结构中,MP-BGP EVPN控制平面对等和VXLAN隧道终止需要建立到环回接口的IP可达性。在ESP架构中,用于共享站点间环回可达性的协议是使用IPv4单播地址族的外部BGP(eBGP)。

MP-BGP通过AS号来确定BGP发言者的管理关系。拥有相同AS号的BGP对等体属于同一管理域,被称为内部对等体(iBGP)。而具有不同AS号的BGP对等体则被视为外部对等体(eBGP)。iBPG和eBPG之间存在不同的默认行为和规定。由于默认的eBPG行为在网络设计上很实用,因此它常被应用在组织内部各个不同网络段之间。

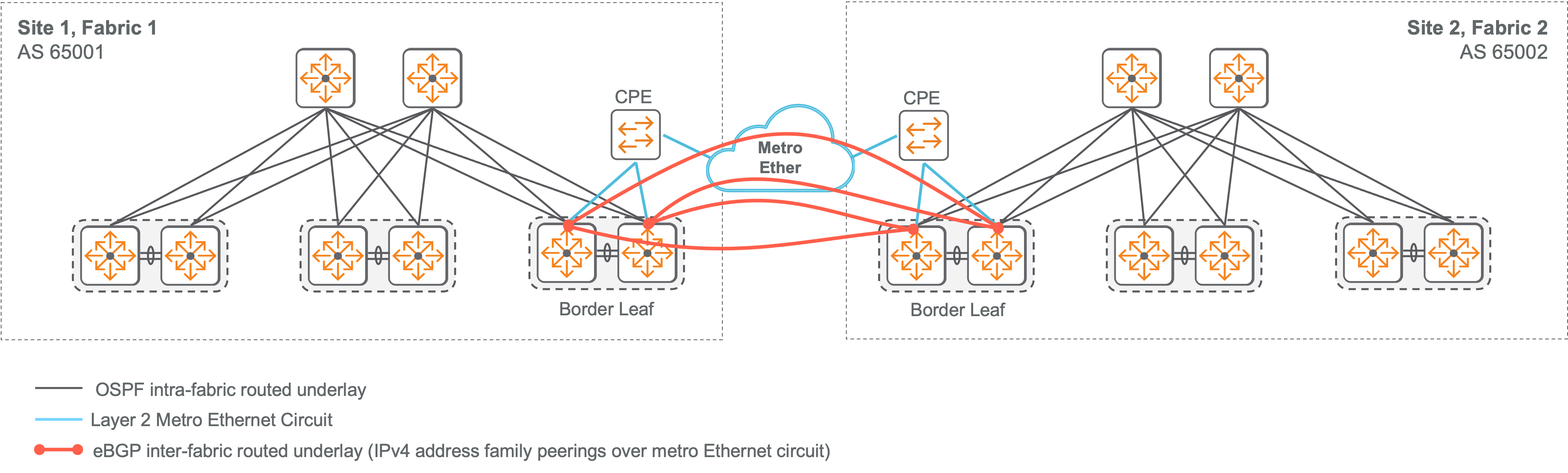

以下图解展示了两个fabric结构中的边界leaf交换机之间一组eBPG IPv4地址族的对等关系。这些站点通过城域以太网实现二层连接。每个边界leaf交换机上的路由接口都会与远程fabric中的每一个边界leaf交换机建立对等关系。它们共享环回IP地址,以便建立MP-BPG EVPN对应关系和VTEP隧道终结。

通常,底层的eBGP对等会遵循网络位置之间的物理链接。这些链接可能与控制平面EVPN对等并不直接相符。暗光纤和城域以太网电路是连接站点之间的常见选项。

随着互联fabric的数量增加,主站点所需的高速电路可能会超过边缘Leaf交换机上的可用端口数。Spine交换机上的高速端口可以被用于多个fabric底层。WAN路径和MP-BGP IPv4对等会根据环境变量和设计偏好进行调整。

多fabric数据层网络

VXLAN隧道技术能够将二层和三层域扩展到多个EVPN-VXLAN fabric中。这些fabric可以分布在同一数据中心的不同pod,也可以跨越同一园区内的多个数据中心,甚至是更远距离的数据中心。连接各个数据中心fabric的链接被称为数据中心互连(DCI)。

在fabric之间扩展二层和3层网络段时,需要使用相同的VNI值。例如,所有fabric中的VLAN 20的二层 VNI 值以及VRF 1的3层VNI值必须保持一致。

VXLAN隧道仅在边界Leaf交换机之间设置,以优化本地和多fabric的可扩展性。只需在这些交换机之间建立完全网状隧道,就无需在所有fabric中的每个VTEP之间创建VXLAN隧道。

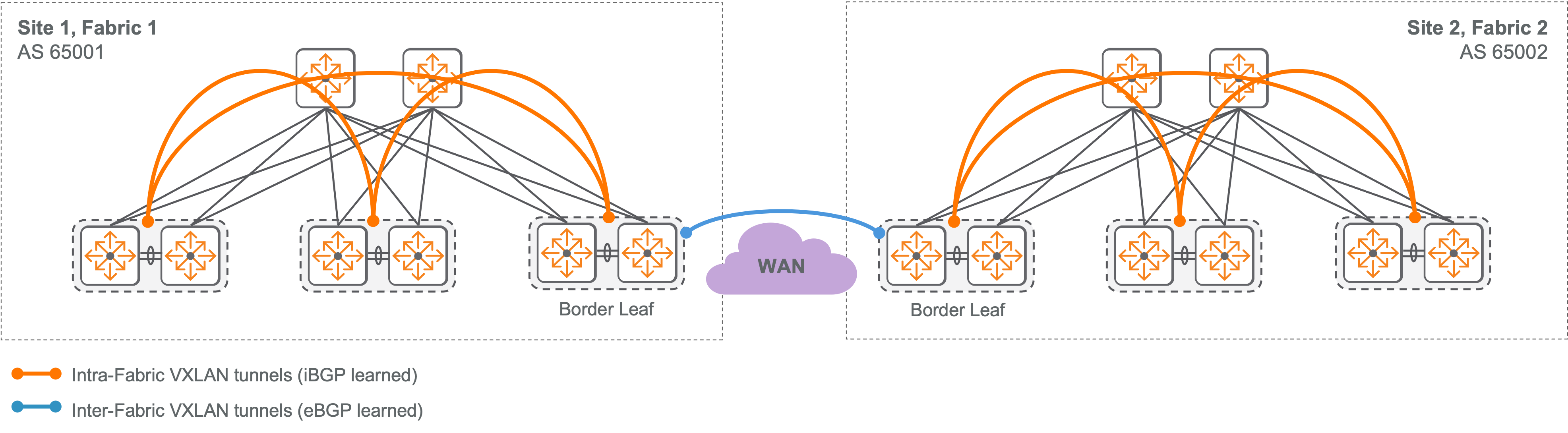

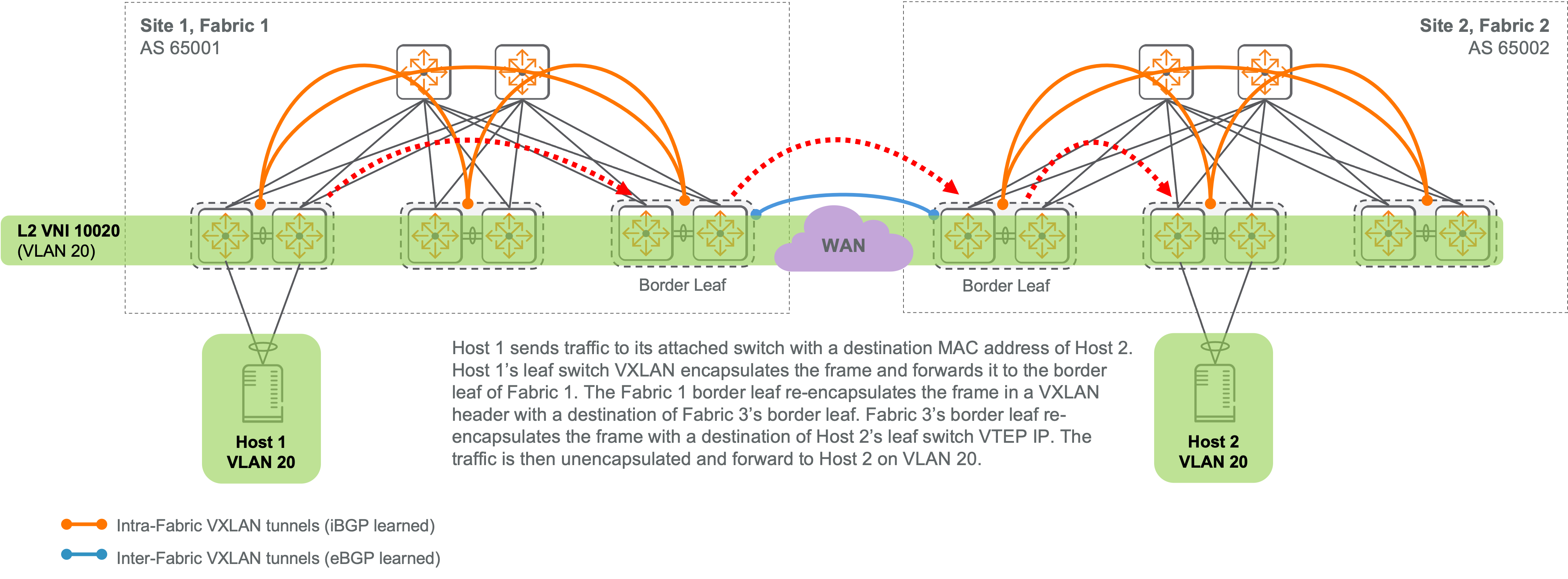

以下图解展示了两个fabric拓扑结构中,inter-fabric和internal fabric的VXLAN隧道情况。

在本地Fabric网络中,所有主机间的VXLAN隧道流量都是在单一源VTEP封装,并在单一目标VTEP解封装。每两台主机之间都存在一个逻辑隧道。由于所有VTEP之间形成了完全网状的VXLAN隧道,这种转发模型得以实现。

在多fabric拓扑中,不同fabric的主机间流量最多可通过三个VXLAN隧道。默认情况下,Aruba交换机禁止将接收到的VXLAN隧道内流量转发至另一个VXLAN隧道。为实现多fabric主机的连通性,必须取消这一限制。但为防止单个fabric出现转发循环,只能在iBGP和eBGP动态学习到的隧道之间取消VXLAN重封装。在fabric内部, iBGP用于发现VXLAN VTEP并动态构建VXLAN隧道;而eBGP则用于识别VTEP并建立各fabric间的VXLAN隧道。

当主机在叠加层上跨fabric通信时,流量会在源主机直接连接的leaf交换机处被封装,并将目标VTEP设为同一fabric的边界leaf。然后,源fabric中的边界leaf会对流量进行重新封装,其目标VTEP是目标fabric中的边界leaf。最后,目标fabric中的边界leaf再次对流量进行重新封装,此时VTEP指向直接与目标主机相连的leaf交换机。

在由三个或以上fabric构成的多fabric拓扑中,边界Leaf交换机之间建立了一套完整的VXLAN隧道网络。

多Fabric叠加控制层

MP-BGP EVPN被用作多重fabric叠加的控制平面,与在单一fabric叠加中的应用相同。

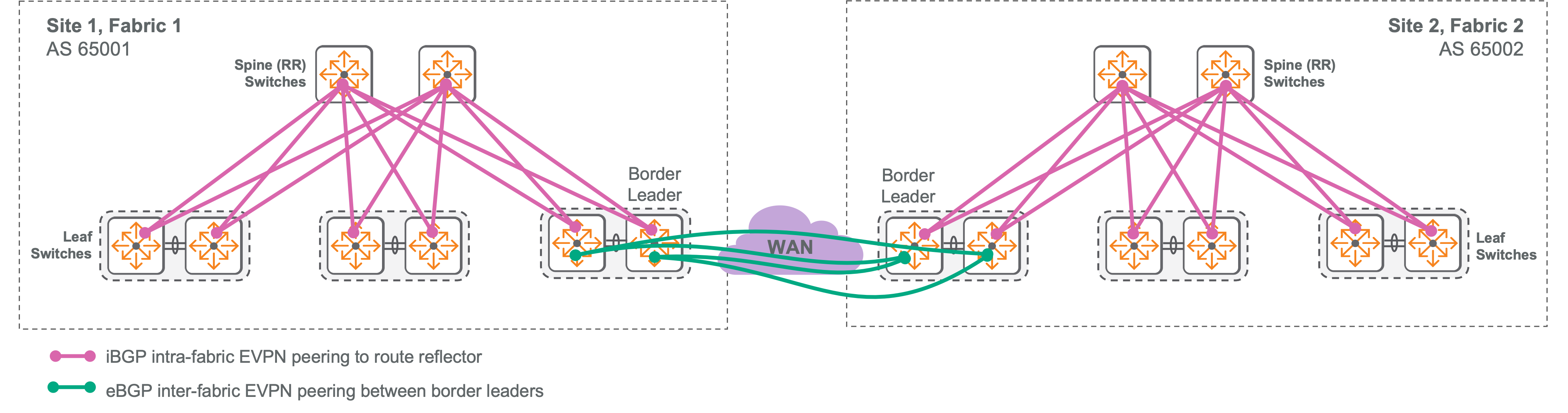

iBGP在每个fabric内部被应用。在每个fabric中,所有的Leaf交换机都会与两个Spine交换机上的路由反射器建立MP-BGP EVPN地址族的对等连接。

使用eBGP在不同的fabrics之间进行通信,以便VXLAN流量可以被重新封装并在第二个隧道中转发。这是利用了有助于多fabric环境的默认行为。

当一个地点有多个fabric时,通常只需要一组边缘Leaf交换机通过可用的WAN路径与外部fabric建立MP-BGP EVPN地址族对等关系。在站点间进行对等的这些边缘Leaf被称为border leader。

下图展示了在两个fabric拓扑中的MP-BGP EVPN对等连接。

定义了附加的路由目标值,用于在fabric之间安装可达性信息。每个VLAN和VRF在初始创建时都会被分配一个intra-fabric路由目标。管理员配置了一个全局路由目标,该目标在用于扩展VLAN和VRF网络段的fabric之间共享。这种策略允许那些不应跨所有fabric扩展的网络段独立存在,并保持作为仅限本地fabric叠加部分。

例如,假设有三个fabric,它们各自的堆叠中都包含VLAN 20。我们可以分配EVPN 路由目标(RT)使得两个fabric能共享VLAN 20主机的可达性,但第三个fabric则不能。以下是实现这一目标的路由目标分配示例。

- Fabric 1, VLAN 20 — Local RT: 65001:20, Global RT: 1:20

- Fabric 2, VLAN 20 — Local RT: 65002:20, Global RT: 1:20

- Fabric 3, VLAN 20 — Local RT: 65003:20

当将IP路由前缀扩展到不同的fabric时,全局路由目标也会被分配给VRF。

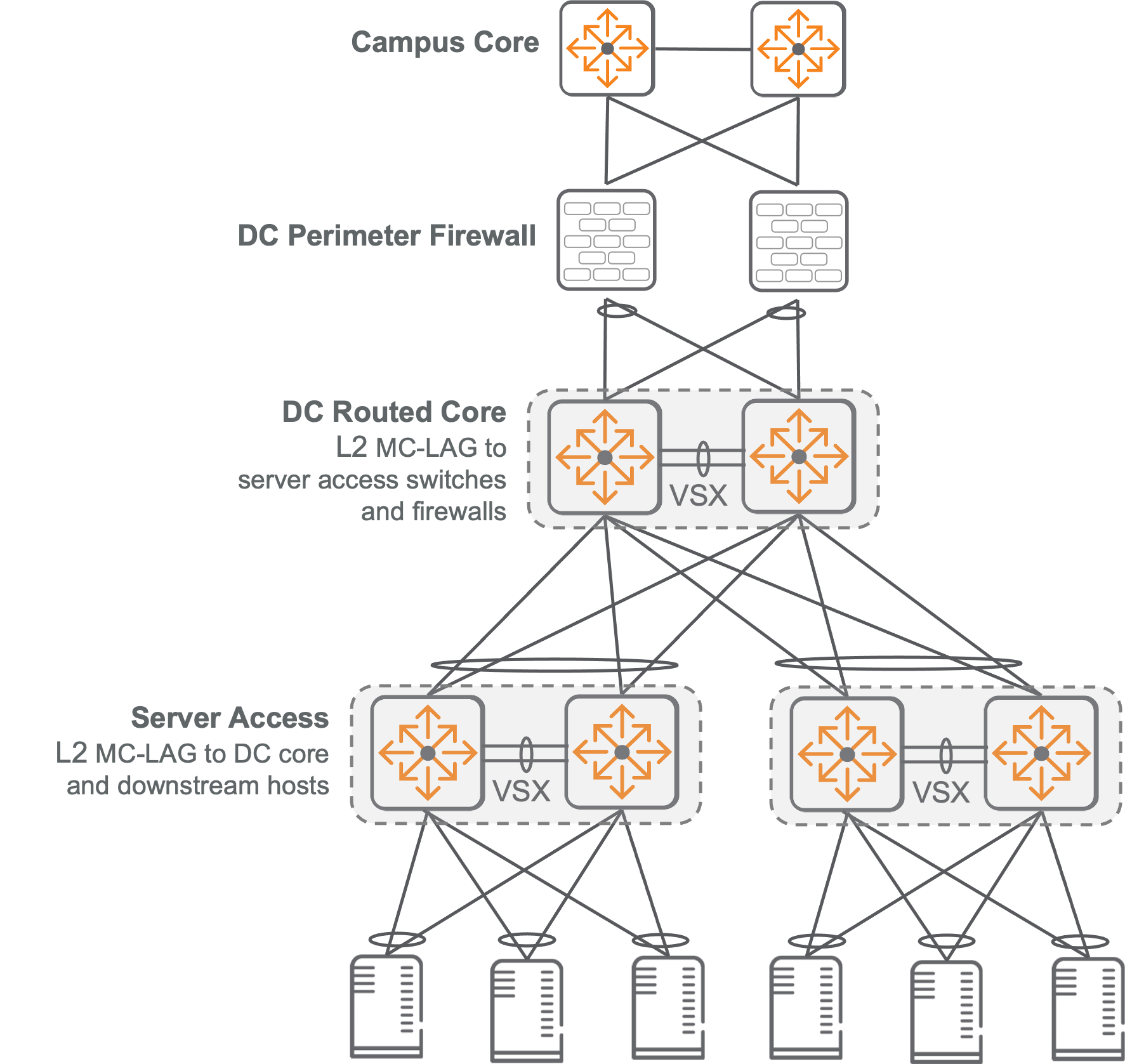

两层数据中心(Two-Tier Data Center)

这个两层设计采用了传统协议,使得部署、操作和故障排除变得简单,无需具备专门的叠加协议或设计知识。虽然这种架构主要适合中小型数据中心,但也可以在大型环境下的每一个数据中心Pod上实施。

VSG采用两层结构,包括由折叠路由/二层核心和仅配置接入交换机的二层组成的多机箱LAG。相比之下,Spine-Leaf网络则使用Spine-Leaf间的路由链接。

在两层数据中心中,主机信息是通过传统的桥接学习和ARP方法进行交换的。

拓扑概述

两层数据中心网络在核心层实现了汇聚和3层服务,同时在接入层提供端点连接。所有的接入交换机都通过MC-LAG与两个核心交换机进行二层连接,以达到负载均衡和容错的目标。

L2的两层设计物理布局与双Spine Spine-Leaf架构相符,这为未来使用3层Spine-Leaf底层的EVPN-VXLAN叠加迁移提供了可能性,同时也保护了在两层网络设备上的投资。

核心设计

核心层部署了一对高密度、高带宽端口的VSX交换机。这需要两个核心交换机使用相同型号并运行相同版本的固件。

在两层架构中,核心交换机的端口容量决定了能支持的最大机柜数量。对于冗余ToR设计,最大机柜数量等于核心交换机总端口数减去VSX和园区链接后的差值除以二(忽略任何余数)。例如,一个32端口的交换机如果使用两个VSX链接和两个园区上行链路,则可以支持14个冗余ToR机柜:(32-4) / 2 = 14。而对于非冗余、单一交换机ToR设计,所能支持的机柜数量则是核心交换机模型的端口计数减去VSX和园区链接后得到的结果。

核心交换机模型也决定了数据中心骨干网络的最大容量。相较于基于二层的两层架构,3层Spine-Leaf架构能通过增加Spine交换机来提升东西向吞吐能力。例如,在双Spine结构中,添加一个Spine可以将容量提高50%,再添加两个则可使其翻倍。在L2两层设计中,只有一对VSX交换机位于内部以支持从机柜到机柜的通信。因此,对L2两层数据中心进行容量规划至关重要,因为大规模升级往往需要更换硬件。

接入到核心的连接通常是使用四通道SFP(QSFP)收发器或AOC的40Gbps或100Gbps光纤。当在核心和接入角色中都使用CX 9300时,支持400 Gbps的接入到核心互连,以支持更高速度的数据中心应用。

通过升级到更快的收发器或在核心层和接入层之间增加MC-LAG的链接,可以提高初始容量。但是,每个LAG中链接的增加会因为核心端口消耗的增加而显著减少支持的机柜数量。

有时,为了提供高带宽的集中式服务,部分机柜需要更高容量的核心链路。请注意,核心和接入交换机之间不一致的上行链路容量会影响主机的移动性,因为需要增加带宽的虚拟机只能连接到交换机的子网。

核心层为接入交换机提供了二层汇聚点。在不同机柜中,相同VLAN的主机间流量会通过配置在MC-LAG trunk(位于核心与接入交换机之间)上的VLAN穿越核心层。通过使用 802.1Q VLAN 标记将所有数据中心VLAN分配给核心交换机和接入交换机之间的所有MC-LAG链路,可实现两层实例内无处不在的二层主机移动性。

VSX上的Active Gateway支持在两个核心交换机上使用相同IP地址,无需使用 VRRP 等冗余网关协议。

核心层为数据中心主机提供所有3层功能,并提供与外部网络和服务的连接点。

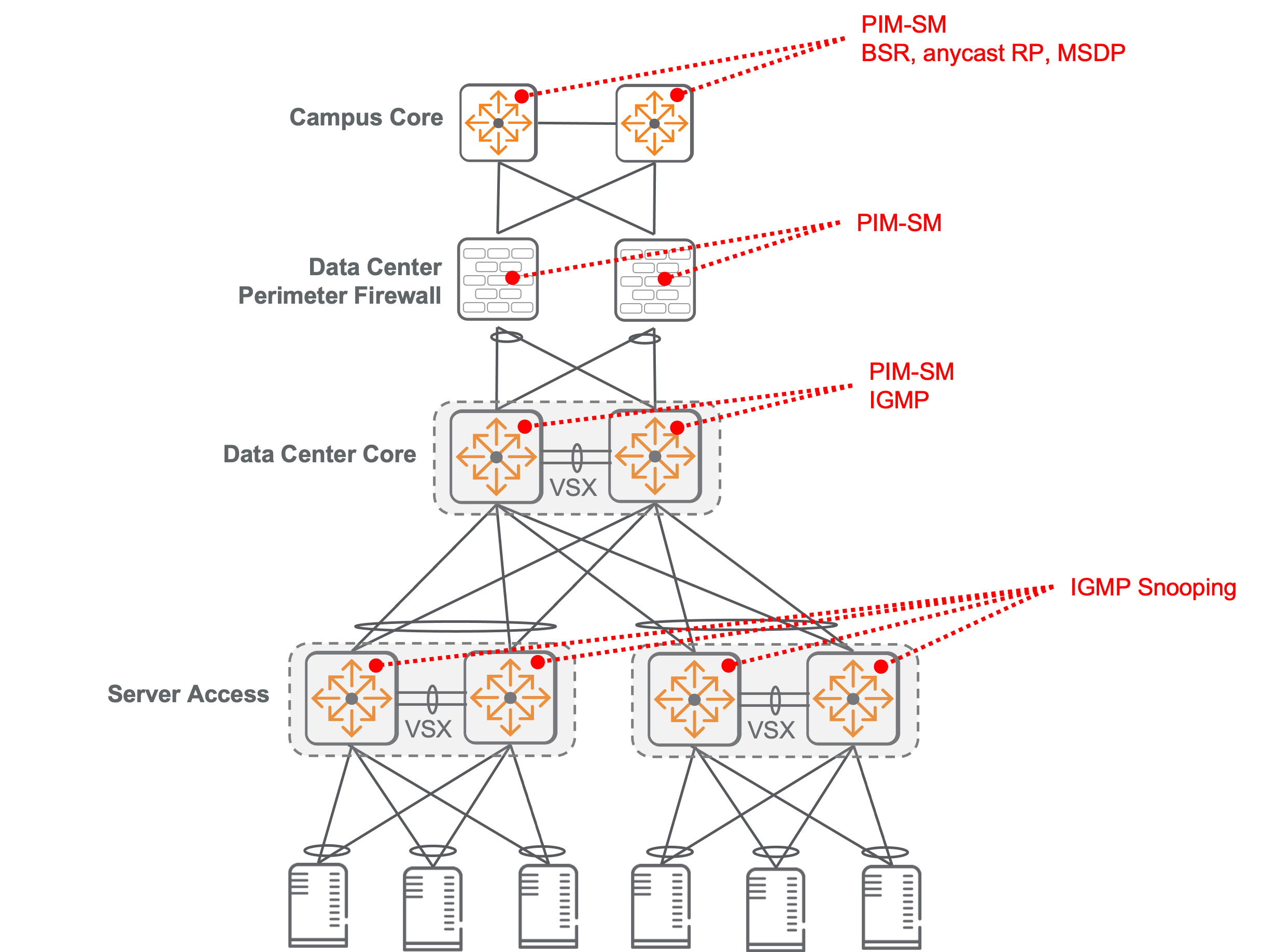

组播操作

组播是一种向多台主机发送相同流量的有效方法,它将流量从一个源转发给一组感兴趣的监听者,从而使一个流量流到达多个接收者。组播流量被发送到 224.0.0.0/4 块中的目标IP地址,而不是单个主机IP,该块中的每个IP地址被称为一个组播组。

ESP数据中心支持数据中心内主机之间的组播流量,以及数据中心与外部主机之间的流量(无论源在哪一侧)。协议无关组播–稀疏模式(PIM-SM)管理组播流量,以支持运行。

一个PIM-SM组播域,即一组连续的PIM-SM路由器,使用一个或多个汇聚点(RP)来维护组播组与其源IP地址的集中映射。通常,一个PIM域包括执行路由功能的全部园区和数据中心交换机,并使用单个任播IP地址作为所有组播组的RP。RP的任播IP在两个不同的交换机上配置以实现冗余。组播源发现协议(MSDP)用于在共享RP任播IP地址的两台交换机之间分享组播组信息。

PIM使用自举路由器 (BSR) 机制动态选择RP地址并将RP信息分布到整个PIM域。BSR过程减少了手动配置所有执行组播路由CX交换机上的RP信息所带来的管理负担。在一个PIM域中,有些PIM-SM路由器被标识为候选BSR,并通过选举过程从中选择出一台作为BSR 。配置为候选RP的PIM-SM路由器向BSR通告指定接口IP作为可能RP。可以使用环回接口地址确保IP地址始终处于启用状态。BSR从候选 RP中选择一台作为该域内RP,然后通知PIM域能够访问到已经被选择出来RP的IP地址给其他成员。候选RP可以被分配优先级值来影响RP的选择过程。当使用任播RP时,两个候选RP通告相同的IP环回地址,并具有相同的优先级值。

在两层数据中心中,核心层交换机作为PIM-SM路由器运行。它们支持数据中心主机之间以及数据中心与外部网络之间的组播路由。通常情况下,数据中心核心交换机通过BSR机制学习园区RP的IP地址。数据中心和园区之间共享RP确保所有组播组都可以在网络之间进行访问。两层核心交换机将直接连接的组播源报告给园区RP。

下图展示了与两层数据中心相关的组播角色。

当PIM-SM路由器检测到对特定组播组感兴趣的监听器时,它会建立转发状态,以便源头的流量能够抵达这些监听器。数据中心核心交换机运用互联网群组管理协议(IGMP)在面向主机的路由接口上运行,从而找出对接收组播流量有兴趣的主机。如果一个主机想要接收目标为组播组地址的流量,它就会发送一个IGMP加入请求,并由数据中心核心交换机进行处理。

接入层通过使用IGMP snooping来优化组播流量的转发。如果没有这种优化,组播流量会被广泛洪涝到同一VLAN的所有端口,并由对此类流量不感兴趣的主机处理。IP组播组与相应的MAC地址有关联。二层接入交换机会观察IGMP加入操作并更新与IP组播组相关联的MAC地址在二层转发表中。这样可以确保只有在检测到进行了IGMP加入操作的界面上,才能将组播流量正确地转发给预期接收者。

MAC地址与IP组播组之间不存在直接的对应关系。一个组播组的IP地址最后23位会被添加到以01:00:5E为标识符(OUI)的MAC地址上。因此,每个MAC地址可以代表32个IP组播组。在选择应用程序的组播地址时,需要考虑这一点以优化二层转发效率。

接入交换机设计

在两层架构中,每个架顶接入交换机都通过MC-LAG与两个核心交换机连接,以实现链路的负载均衡和故障冗余。

建议使用VSX的冗余架构来提高利用MC-LAG的下游主机的故障冗余能力。虽然通过实施MC-LAG和LACP,接入交换机与核心交换机之间的二层连通性已经无环,但我们仍配置生成树协议(STP)作为备份策略,以防止数据中心管理员在一个机柜内部意外创建环路。此外,我们还为核心VSX对设置一个STP优先级,确保其被选为STP根节点。

相较于多重生成树(MST)实例,MC-LAG能更有效地利用核心与接入交换机间的链接,因为所有冗余链接都保持活跃以发送流量。流量转发是通过哈希算法选择单一LAG成员链接进行的,并且这种应用方式精确到每个流程。虽然MST实例也可以使用多链路在接入和核心之间提供故障冗余并平衡流量,但其负载均衡策略需要静态配置,并限制了将流量主动转发到基于每个VLAN的单一冗余链路上。